Khi công nghệ phát triển, website không chỉ là nơi cung cấp thông tin mà còn là mục tiêu của nhiều cuộc tấn công từ bot và các phần mềm tự động khác. Để bảo vệ website khỏi những mối đe dọa này, việc chặn User Agent/Bot là vô cùng cần thiết. Bài viết này sẽ hướng dẫn bạn cách chặn User Agent/Bot thông qua .htaccess đơn giản.

User Agent/Bot là gì?

User Agent (UA) là một chuỗi ký tự được gửi từ trình duyệt web đến máy chủ khi người dùng truy cập một trang web. Chuỗi ký tự này chứa thông tin về loại trình duyệt, phiên bản, hệ điều hành và một số thông tin khác liên quan đến thiết bị mà người dùng đang sử dụng. Ví dụ, khi bạn sử dụng Google Chrome trên Windows, User Agent sẽ cho biết rằng bạn đang sử dụng trình duyệt Chrome và hệ điều hành Windows.

Bot, hay còn gọi là web crawler hoặc spider, là một loại chương trình tự động thực hiện các tác vụ trên internet, như thu thập dữ liệu từ các trang web. Các bot này cũng có User Agent riêng, cho phép máy chủ nhận diện chúng. Ví dụ, Google Bot, một bot của Google, có User Agent đặc trưng giúp các webmaster nhận biết rằng đây là bot của Google đang thu thập thông tin cho công cụ tìm kiếm .

Việc hiểu rõ về User Agent và bot là rất quan trọng, đặc biệt trong việc quản lý và bảo vệ website khỏi các bot không mong muốn, cũng như tối ưu hóa trải nghiệm người dùng.

Tại sao cần chặn User Agent/Bot thông qua .htaccess?

Chặn User Agent hoặc Bot thông qua tệp .htaccess là một biện pháp quan trọng giúp bảo vệ website khỏi các hoạt động không mong muốn từ các bot tự động hoặc các tác nhân truy cập gây hại. Dưới đây là những lý do chi tiết về việc tại sao cần thực hiện điều này:

Bảo vệ tài nguyên máy chủ

Các bot có thể làm tăng tải trên máy chủ do truy cập vào nhiều trang trong một thời gian ngắn. Điều này sẽ tiêu tốn băng thông, tài nguyên CPU và RAM, dẫn đến việc website có thể trở nên chậm hoặc ngừng hoạt động. Đặc biệt, các website có lưu lượng truy cập lớn sẽ dễ bị ảnh hưởng hơn nếu không kiểm soát được số lượng bot truy cập.

Ngăn chặn bot thu thập dữ liệu trái phép

Một số bot được thiết kế để thu thập nội dung trên website của bạn, như văn bản, hình ảnh, hoặc thông tin khác để phục vụ cho mục đích không hợp pháp, chẳng hạn như sao chép nội dung (content scraping). Việc chặn các bot này giúp bảo vệ nội dung độc quyền của website, tránh việc bị sao chép và đăng tải lại trên các trang khác, làm giảm giá trị SEO và uy tín của website.

Bảo vệ an ninh và dữ liệu người dùng

Một số bot có thể được thiết lập để tìm kiếm các lỗ hổng bảo mật, từ đó khai thác thông tin cá nhân của người dùng hoặc dữ liệu nhạy cảm. Việc ngăn chặn chúng qua .htaccess giúp giảm thiểu nguy cơ bị tấn công và bảo vệ an toàn cho dữ liệu người dùng.

Các bot xấu thường nhắm đến các lỗ hổng phổ biến như SQL Injection, Cross-Site Scripting (XSS), nên việc chặn chúng sẽ giảm nguy cơ bị khai thác bảo mật.

Cải thiện hiệu suất và trải nghiệm người dùng

Khi các bot xấu bị chặn, máy chủ sẽ tiết kiệm được tài nguyên, giúp website hoạt động mượt mà và nhanh chóng hơn cho người dùng thực tế.

Hiệu suất trang web tốt hơn sẽ cải thiện trải nghiệm người dùng, giữ chân khách hàng và nâng cao khả năng SEO vì Google thường ưu tiên các trang có tốc độ tải nhanh.

Tăng cường khả năng SEO

Một số bot có thể thực hiện các hành vi gây tổn hại đến SEO của website, chẳng hạn như spam backlink hoặc thu thập dữ liệu không cần thiết. Việc chặn các bot này giúp website duy trì chất lượng SEO tốt hơn.

Ngoài ra, ngăn chặn các bot sao chép nội dung giúp bảo vệ tính độc quyền của nội dung và ngăn ngừa việc các trang sao chép có thể chiếm lĩnh thứ hạng tìm kiếm.

Giảm thiểu nguy cơ spam

Nhiều bot có thể tự động tạo các bình luận hoặc form spam trên website, làm tăng lượng dữ liệu rác. Điều này không chỉ gây phiền toái mà còn ảnh hưởng đến uy tín và trải nghiệm của người dùng.

Việc chặn các bot spam qua .htaccess giúp giảm thiểu thời gian và công sức dành cho việc xử lý các bình luận và form spam.

Cách chặn User Agent/Bot bằng .htaccess

Chuẩn bị trước khi thực hiện

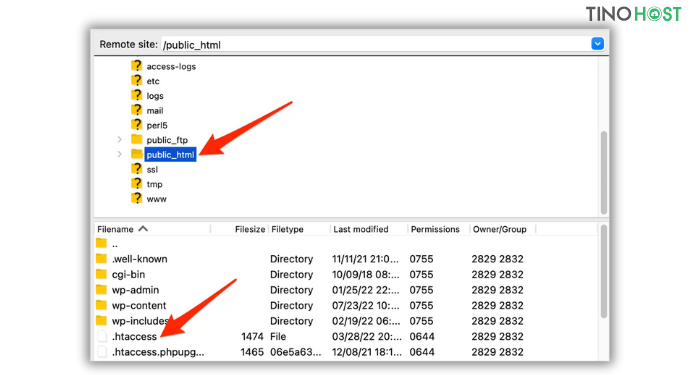

Đảm bảo rằng bạn có quyền truy cập và quyền sửa đổi tệp .htaccess của trang web. Thông thường, tệp .htaccess nằm trong thư mục gốc của website (thư mục public_html hoặc www).

Ngoài ra, trước khi thực hiện bất kỳ thay đổi nào, bạn nên sao lưu tệp .htaccess hiện tại để có thể khôi phục lại nếu xảy ra lỗi.

Cấu trúc cơ bản để chặn User Agent/Bot

Trong tệp .htaccess, bạn có thể sử dụng các dòng lệnh sau để chặn các User Agent hoặc bot cụ thể:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "EvilScraper" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "SpamBot" [NC]

RewriteRule .* - [F,L]Trong đó:

- RewriteEngine On: Bật công cụ Rewrite để xử lý các quy tắc.

- RewriteCond %{HTTP_USER_AGENT} “BadBot” [NC,OR]: Điều kiện này xác định tên User Agent “BadBot” và chặn nó. [NC] là tùy chọn để không phân biệt chữ hoa chữ thường, [OR] dùng để nối điều kiện nếu có nhiều User Agent cần chặn.

- RewriteRule .* – [F,L]: Quy tắc này trả về mã lỗi 403 Forbidden, ngăn chặn truy cập từ các bot được chỉ định.

Chặn nhiều User Agent cùng lúc

Nếu có nhiều User Agent cần chặn, bạn có thể nối nhiều điều kiện với OR. Ví dụ:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "EvilScraper" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "SpamBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "AnotherBot" [NC]

RewriteRule .* - [F,L]Lưu ý: Đảm bảo rằng chỉ điều kiện cuối cùng không có [OR], để tránh lỗi cú pháp.

Chặn nhiều User Agent cùng lúc

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "EvilScraper" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "SpamBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "AnotherBot" [NC]

RewriteRule .* - [F,L]Chặn các User Agent cụ thể một cách chính xác

Để tránh chặn nhầm các bot hợp pháp như Googlebot (bot của Google) hoặc Bingbot (bot của Bing), bạn cần xác định đúng User Agent của bot cần chặn. Bạn có thể tra cứu tên User Agent của bot trên các trang như user-agents.io.

Chặn toàn bộ các User Agent không xác định

Đôi khi, có các bot không gửi User Agent rõ ràng. Bạn có thể chặn các truy cập mà không xác định rõ User Agent bằng cách thêm mã sau:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ^-?$ [NC]

RewriteRule .* - [F,L]Điều kiện RewriteCond %{HTTP_USER_AGENT} ^-?$ [NC] sẽ kiểm tra các truy cập với User Agent trống hoặc không xác định và chặn chúng.

Chặn truy cập từ các IP của bot gây hại

Ngoài chặn User Agent, bạn có thể chặn truy cập từ các địa chỉ IP của bot gây hại. Điều này có thể được thực hiện bằng cách thêm mã sau vào .htaccess:

<RequireAll>

Require not ip 123.45.67.89

Require not ip 98.76.54.32

</RequireAll>Thay 123.45.67.89 và 98.76.54.32 bằng các địa chỉ IP của bot mà bạn muốn chặn.

Kiểm tra và xác minh

Sau khi thực hiện các thay đổi, hãy kiểm tra trang web của bạn để đảm bảo rằng tất cả hoạt động bình thường và không có bot hợp pháp nào bị chặn nhầm.

Bạn cũng có thể sử dụng công cụ như Google Search Console để kiểm tra xem các bot tìm kiếm hợp pháp có gặp sự cố khi thu thập dữ liệu trang web của bạn hay không.

Ví dụ cụ thể

Dưới đây là một ví dụ đầy đủ kết hợp các cách chặn bot phổ biến bằng .htaccess:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} "BadBot" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "EvilScraper" [NC,OR]

RewriteCond %{HTTP_USER_AGENT} "SpamBot" [NC]

RewriteRule .* - [F,L]

RewriteCond %{HTTP_USER_AGENT} ^-?$ [NC]

RewriteRule .* - [F,L]

<RequireAll>

Require not ip 123.45.67.89

Require not ip 98.76.54.32

</RequireAll>Lưu ý quan trọng:

- Luôn kiểm tra lại hoạt động của website sau khi chỉnh sửa .htaccess.

- Tránh chặn các User Agent hợp pháp, vì điều này có thể làm giảm khả năng SEO của website.

- Định kỳ cập nhật danh sách các User Agent và địa chỉ IP gây hại để đảm bảo bảo mật cho website.

Kết luận

Chặn User Agent hoặc bot qua .htaccess là phương pháp hiệu quả để bảo vệ website của mình khỏi các bot xấu và cải thiện hiệu suất tổng thể của trang web. Tuy nhiên, bạn cần thực hiện một cách cẩn thận và có kiểm tra để không ảnh hưởng đến người dùng thực tế và các bot hợp pháp. Chúc bạn thành công!

Những câu hỏi thường gặp

Cách xác định tên User Agent của bot cần chặn như thế nào?

Bạn có thể xác định tên User Agent của các bot gây hại bằng cách xem các bản ghi (log) truy cập trên máy chủ hoặc sử dụng các công cụ như Google Analytics, cPanel để theo dõi các truy cập đáng ngờ. Ngoài ra, có nhiều trang web liệt kê danh sách các User Agent của bot như user-agents.io.

Làm sao để biết các bot hợp pháp đã bị chặn hay chưa?

Sau khi chặn, bạn có thể kiểm tra bằng cách sử dụng Google Search Console để xem liệu Googlebot có gặp khó khăn khi thu thập dữ liệu website không. Ngoài ra, theo dõi lưu lượng truy cập và kiểm tra các báo cáo truy cập có thể giúp xác định việc chặn có ảnh hưởng đến các bot hợp pháp hay không.

Nếu không biết User Agent của bot, tôi có thể làm gì?

Nếu không biết User Agent cụ thể của bot, bạn có thể kiểm tra các log truy cập của server để xác định các User Agent đáng ngờ. Sau đó, bạn có thể thêm chúng vào file .htaccess để chặn.

Có cách nào khác để chặn bot mà không cần thông qua .htaccess không?

Ngoài việc sử dụng .htaccess, bạn cũng có thể sử dụng file robots.txt để hướng dẫn các bot về những phần của website mà bạn không muốn chúng truy cập. Tuy nhiên, không phải tất cả các bot đều tuân thủ quy tắc trong robots.txt, vì vậy việc sử dụng .htaccess thường hiệu quả hơn.

Chặn User Agent có ảnh hưởng đến SEO không?

Việc chặn User Agent có thể ảnh hưởng đến SEO nếu bạn chặn nhầm các bot của các công cụ tìm kiếm như Googlebot. Do đó, bạn cần phải cẩn thận và chỉ chặn những User Agent mà bạn chắc chắn không cần thiết cho việc tối ưu hóa tìm kiếm.