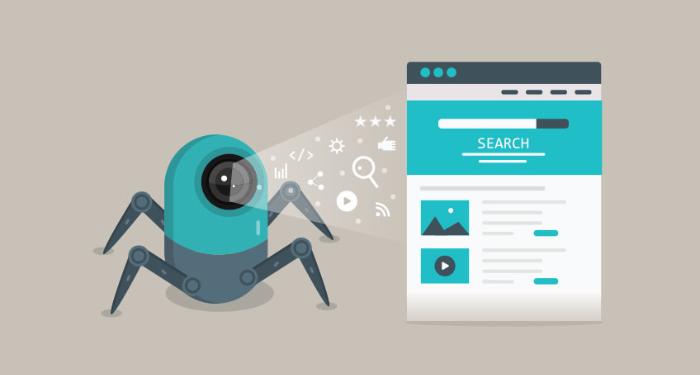

Đối với dân Marketing hoặc những ai có tìm hiểu về web, Crawl không còn là một thuật ngữ xa lạ. Đây cũng chính là kỹ thuật mà robot của các công cụ tìm kiếm (Search Engine) như Google, Bing hay Yahoo, … sử dụng để thu thập thông tin của những website. Trong bài viết này, Tino Group sẽ cùng bạn tìm hiểu cụ thể Crawl là gì cũng như cách hoạt động của Crawl.

Định nghĩa Crawl

Crawl là gì?

Crawl (thu thập thông tin) là một thuật ngữ mô tả quá trình thu thập dữ liệu trên website của những con bot do các công cụ tìm kiếm (Google, Bing, Yahoo…) vận hành.

Thuật ngữ này còn được hiểu như sự “bò trườn”. Trong quá trình thu thập dữ liệu, các con bot sẽ lần lượt truy cập vào từng liên kết trên trang mà chúng bắt gặp rồi tiến hành phân tích mã nguồn HTML để đọc dữ liệu. Sau đó, chúng sẽ lọc theo yêu cầu người dùng hoặc dữ liệu mà công cụ tìm kiếm yêu cầu. Quá trình này chỉ dừng lại khi tất cả liên kết có trên trang đầu và các trang có liên quan đã được “bò trườn” hết.

Dữ liệu thu thập từ những lần Crawl sẽ được gửi về máy chủ tìm kiếm để các Search Engine xem xét và đánh giá trước khi đưa ra quyết định index website.

Web Crawler là gì?

Web Crawler, Spider hay bot là các chương trình phần mềm có nhiệm vụ thu thập thông tin web từ khắp các nơi trên Internet. Mục tiêu của Web Crawler là tìm hiểu (hầu hết) mọi trang trên website xem chúng đang nói về điều gì; từ đó, xem xét truy xuất thông tin khi cần thiết. Các con bot này thường được vận hành bởi các công cụ tìm kiếm.

Googlebot chính là Web Crawler phổ biến nhất hiện nay.

Tại sao cần Crawl dữ liệu?

Cách hoạt động của Web Crawler

Để biết mục đích của Crawl dữ liệu, chúng ta sẽ xem qua cách hoạt động cụ thể của Web Crawler.

Với sự phát triển mạnh mẽ của Internet, con người không thể biết được có bao nhiêu website. Web Crawler sẽ bắt đầu từ một danh sách các URL có sẵn và ghi nhận dữ liệu ở những URL đó. Sau đó, chúng sẽ tìm thấy những siêu liên kết (hyperlink) đến các URL khác và bổ sung các liên kết vừa tìm được vào danh sách ban đầu.

Quá trình này có thể kéo dài vô thời hạn do có số lượng lớn các trang web trên Internet được lập chỉ mục để tìm kiếm. Tuy nhiên, Web Crawler vẫn phải tuân thủ vài chính sách để xác định cụ thể trang nào cần ghi nhận dữ liệu, thứ tự thu thập thông tin ra sao kèm tần suất hợp lý để rà soát và đánh giá cập nhật nội dung.

Thông thường, trang web nào được nhiều website khác trích dẫn, liên kết và có traffic lớn thì chứng tỏ trang web đó có thông tin chất lượng. Vì vậy, công cụ tìm kiếm sẽ nhanh chóng index ngay.

2 khái niệm cần quan tâm là Revisiting Webpages và Robots.txt

- Revisiting Webpages: Đây là thủ tục khi Web Crawlers tiến hành cập nhật các trang theo định kỳ để index những nội dung mới nhất. Bởi nội dung trên trang web thường xuyên được cập nhật, thay đổi, xóa bỏ hoặc di chuyển tới những nơi khác.

- Giao thức Robots.txt: Việc các trang có được thu thập thông tin thông qua giao thức Robots.txt hay không cũng sẽ do Web Crawler quyết định. Web crawlers sẽ tiến hành kiểm tra tệp Robots.txt do máy chủ trang web đó lưu trữ, sau đó mới bắt đầu thu thập thông tin.

Những thành tố này có trọng số không giống nhau tùy vào những thuật toán mà mỗi công cụ tìm kiếm tự thiết lập cho các Web Crawler của họ mặc dù mục đích cuối cùng vẫn là index website.

Crawl tác động đến SEO như thế nào?

Crawl là hoạt động rất quan trọng đối với SEO. Vì công cụ tìm kiếm phải thu thập được dữ liệu mới có thể phân tích, index (lập chỉ mục) và xếp hạng nội dung trên website bạn. Ví dụ, nếu Googlebot không thu thập được nội dung, website sẽ vĩnh viễn không xuất hiện trên Google.

Do đó, nếu muốn SEO được tối ưu, bạn phải kiểm tra xem website của mình có thân thiện với Web Crawl chưa, bộ code đã tối ưu theo hướng dẫn của Google chưa hay file robots.txt đã cấp quyền cho bot vào thu thập dữ liệu chưa.

Các yếu tố ảnh hưởng đến quá trình Crawl của Google

Domain

Domain (tên miền) được Google đánh giá tốt sẽ giúp quá trình Crawl website thuận lợi. Website sẽ có được thứ hạng cao trên kết quả tìm kiếm của Search Engine.

Backlink

Dù nội dung của bạn chất lượng nhưng lại không có bất kỳ backlink thì công cụ tìm kiếm sẽ giả định nội dung website của bạn chất lượng kém. Vì vậy, backlinks sẽ giúp website được công cụ tìm kiếm tin tưởng hơn.

Internal Links

Internal Links là các liên kết dẫn đến các bài viết nội bộ website. Link liên kết nội bộ còn giúp giảm tỷ lệ thoát trang, tăng thời gian onsite của người dùng. Vì vậy, đây là yếu tố bắt buộc khi SEO.

XML Sitemap

Sitemap có thể giúp Google index bài viết mới hoặc những thay đổi, cập nhật nhanh nhất có thể.

Duplicate Content

Viêc để nội dung trùng lặp nội dung sẽ bị Google đánh dấu. Lỗi này có thể khiến website của bạn bị phạt và rời khỏi kết quả tìm kiếm. Bạn có thể khắc phục bằng cách sử dụng phương pháp chuyển hướng 301 và 404 để được Crawl tốt hơn.

URL Canonical

Tạo URL tối ưu và thân thiện với SEO cho mỗi bài viết trên website sẽ giúp Google dễ dàng nhận diện và tăng thứ hạng cho trang web của bạn.

Meta Tags

Meta tag là các thẻ được sử dụng trong các tài liệu HTML và XHTML nhằm cung cấp siêu dữ liệu (metadata) có cấu trúc về một trang web. Việc thêm Meta tag độc đáo, không trùng nhau sẽ đảm bảo website có thứ hạng cao trên công cụ tìm kiếm.

Cách để can thiệp vào quá trình Crawl dữ liệu của công cụ tìm kiếm

Tạo mới nội dung trên trang thường xuyên hơn

Bạn hãy đăng các bài viết mới đều đặn mỗi ngày và vào một khung giờ nhất định (chính xác càng tốt) để tạo một lịch đăng bài mặc định với công cụ tìm kiếm. Từ đó, quá trình Crawl và index thông tin sẽ diễn ra nhanh hơn.

Những website có một lượng lớn dữ liệu, nhiều traffic hoặc các trang web hoạt động uy tín sẽ có tần suất Crawl dữ liệu dày đặc hơn.

Sử dụng các công cụ hỗ trợ Crawl và index

Các công cụ như Google Submit Url hay Google Fetch của Search Console có thể giúp kéo Web Crawler về website của bạn trong một khoảng thời gian ngắn. Bên cạnh đó, những công cụ này còn có thể giúp website submit một liên kết mới tạo lên kết quả tìm kiếm của Google một cách nhanh chóng.

Web Crawler của các công cụ tìm kiếm phổ biến hiện nay

Googlebot

Googlebot là tên gọi cho trình thu thập dữ liệu website của Google. Googlebot có 2 hình thức thu thập dữ liệu khác nhau là: Googlebot Desktop (trình thu thập dữ liệu trên máy tính) và Googlebot Smartphone (trình thu thập dữ liệu trên điện thoại di động).

Bingbot

Bingbot là một bot thu thập thông tin web được Microsoft triển khai vào tháng 10 năm 2010 cho công cụ tìm kiếm Bing. Bingbot sẽ thu thập các tài liệu trên các trang web web để xây dựng một chỉ mục có thể tìm kiếm cho Bing. Chức năng của Bingbot tương tự như Googlebot của Google.

Yandexbot

Yandexbot là trình thu thập thông tin web của công cụ tìm kiếm của Yandex. Yandex là nền tảng tìm kiếm lớn nhất ở Nga và lớn thứ năm trên toàn thế giới.

Baidu

“Baiduspider” là tên gọi chính thức của trình thu thập thông tin web trên mạng Baidu. Công cụ này thu thập dữ liệu các website, sau đó, trả về các bản cập nhật cho chỉ mục Baidu.

Tóm lại, nếu không đáp ứng các yêu cầu về kỹ thuật web để bot có thể Crawl và thu thập dữ liệu dễ dàng, website của bạn có khả năng không bao giờ xuất hiện trên Google. Hy vọng qua bài viết này, bạn sẽ nắm được một số thông tin cơ bản về Crawl cũng như cách hoạt động của Web Crawler đối với việc thu thập dữ liệu của website.

Những câu hỏi thường gặp

Tại sao các Web Crawler còn được gọi là ‘Spiders’?

Internet được xem như một mạng lưới khổng lồ. Việc gọi các bot của công cụ tìm kiếm là “Spiders” vì chúng thu thập dữ liệu trên khắp các trang web, giống với hình ảnh những con nhện bò trên mạng nhện.

Tóm lại, Web Crawler, Bot, Spiders đều là một.

Có phải Web Crawler sẽ thu thập được tất cả thông tin trên Internet?

Trên thực tế, không có con số chính xác cho việc các Web Crawler của công cụ tìm kiếm có thể thu thập được bao nhiêu thông tin. Một số tài liệu ước tính rằng chỉ 40-70%, tương ứng với hàng tỷ website được index.

Tại sao quản lý bot lại quan trọng đối với quản trị website?

Bot được phân chia thành 2 loại: bot độc hại và bot an toàn. Các bot độc hại có thể gây nguy hiểm cho máy chủ, đặc biệt là tình trạng đánh cắp dữ liệu.

Có nên index website thường xuyên không?

Tùy vào số lượng nội dung trên mỗi trang hoặc số lượng trang trên website mà các chủ trang web sẽ cân nhắc có nên index các tìm kiếm thường xuyên hay không. Vì index quá nhiều có thể gây hỏng máy chủ, tăng chi phí băng thông.

Index là gì?

Index (lập chỉ mục) là quá trình thu thập dữ liệu từ các website trên Internet. Sau đó, dữ liệu sẽ được đánh giá và lưu trữ lại trên cơ sở dữ liệu của công cụ tìm kiếm.

Có phải trang web load càng nhanh thì bot sẽ Crawl càng nhanh?

Đúng. Vì các bot cũng phải tải trang xong thì mới Crawl được. Tuy nhiên, nếu như có nội dung chất lượng thì dù trang web có load chậm, bot vẫn Crawl nhanh.

Có phải Google ưu tiên nội dung cũ hơn nội dung mới?

Không. Google chỉ quan tâm đến giá trị của nội dung và không phân biệt cũ hay mới. Nếu nội dung cũ nhưng vẫn có giá trị trong thực tiễn thì vẫn có thể lên top như thường.

Có phải web nhỏ sẽ không được bot ghé thăm thường xuyên như các web lớn?

Web nhỏ hay lớn không quan trọng, quan trọng là nội dung phải chất lượng, chuẩn SEO và được cập nhật thường xuyên.